昨年末に汎用人工知能のChat GPIが公開され、自然な対話が可能となっており注目を集めてます。最近電子カルテの拡張機能としてText Blazeを使用しているのですが、Chat GPTのAPIを組み込むことによりChat GPTの機能が電子カルテでも利用できるようになっています。

Text Blazeのcommunityの掲示板に記載ありますが、Text BlazeのCommand PackでOpen AIのアクチベーションをするとコマンドで使用できるようになります。例えば

要約{openai-text: 新しい患者の問診です、400文字以内で要約してください:{=text}}

{text={site: text; selector=textarea}}というコードでChat GPTがしばらく考えた後で電子カルテの記載内容を要約したものを打ち出してくれます。

*{text={site: text; selector=textarea}}の部分は使用している電子カルテにより異なります。

さらには

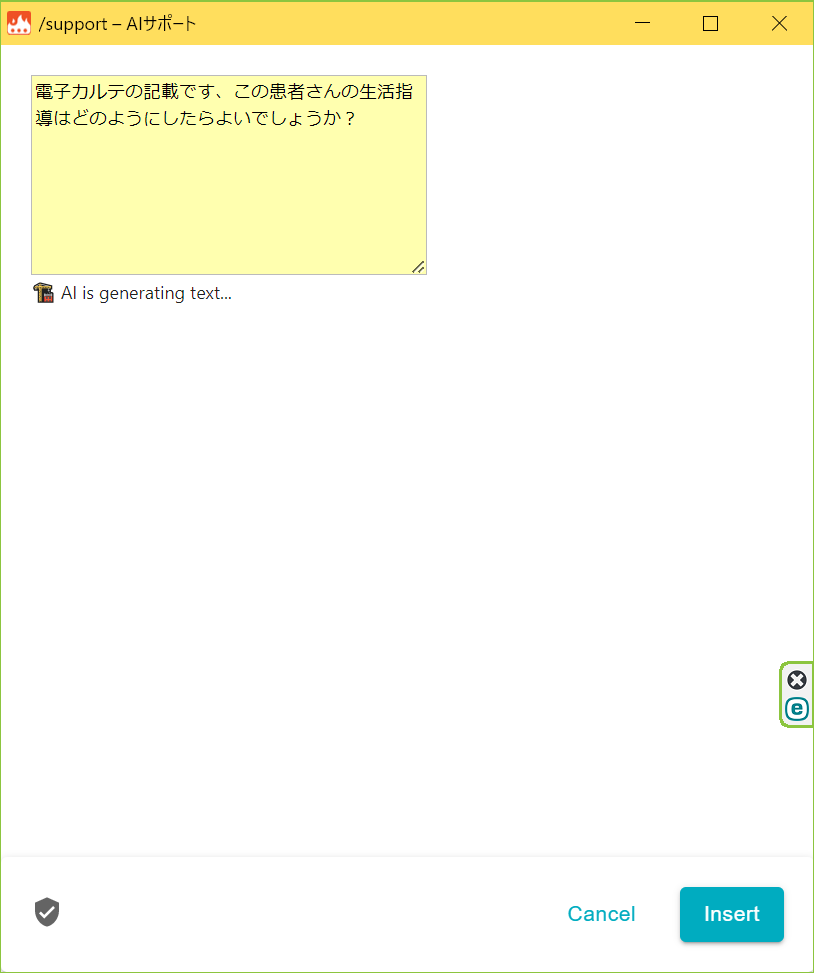

{formparagraph: name=req; cols=40; rows=8}{text={site: text; selector=textarea}}

{openai-text: {=req}:{=text}; format=text}の2行のコードで電子カルテの内容を読み取って自由にChat GPTに指示を与えることができます。

Chat GPTは要約などは得意なのですが鑑別疾患、生活指導のアドバイスなどはまだまだ苦手で変なものを出力してきます。

例えばカルテの内容の記載が、

“

#高血圧

#高脂血症

#下肢の浮腫み

#心筋梗塞 家族歴 (父親‐PCI治療歴)

#肥満 75Kg→68㎏

血圧 148/55 mmHg

体調は去年の11月に仕事が変わり、体重が減った。

“

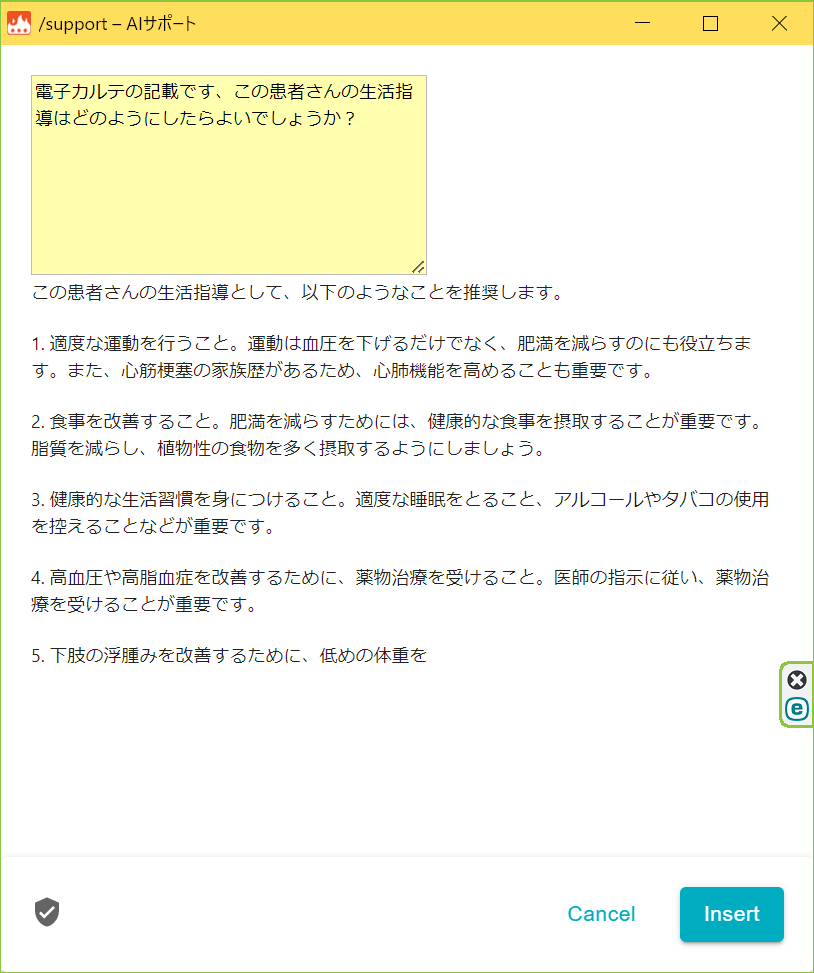

であった場合に下のように生活指導をお願いすると

しばらく考えた後で

のように返事をしてくれます。insertボタンで電子カルテに挿入することが可能です。これが生活指導ならまだそれっぽいのですが、鑑別疾患などになると返信の精度がどんどん落ちてきます。Chat GPT、どれくらいの医学知識があるのだろう?、ということで医師国家試験を解かせてみました。

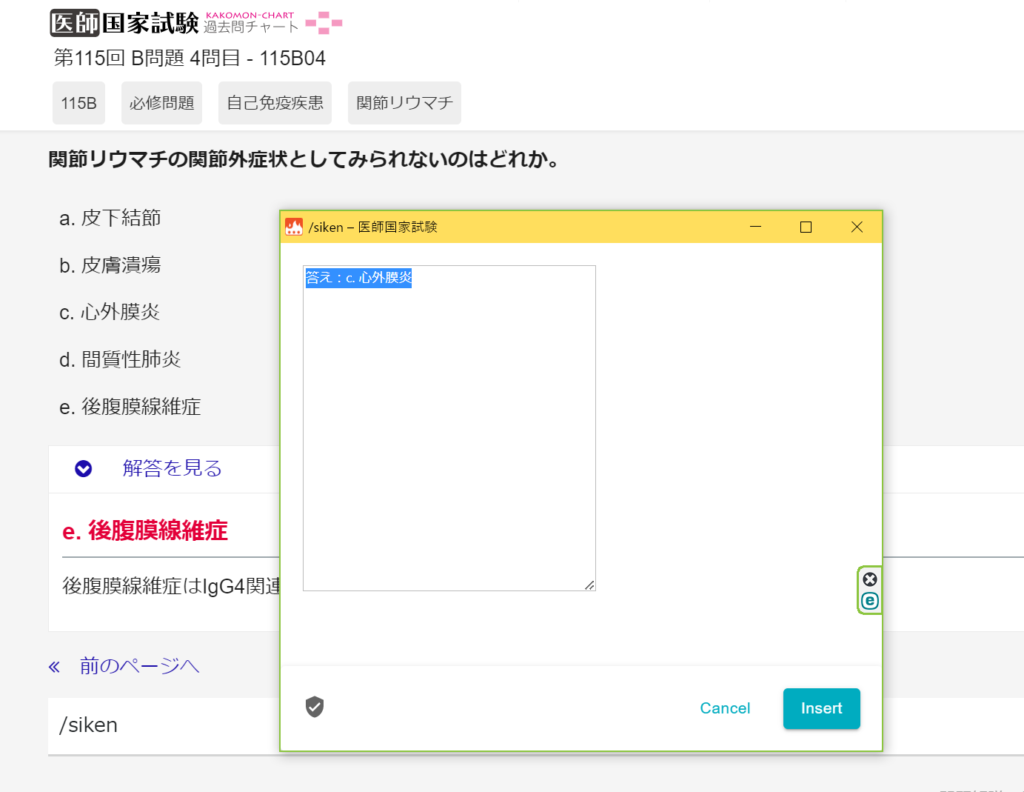

医師国家試験の過去問サイトを利用して解かせてみます。これもコピペでChat GPTに対話形式で解かせることも可能なのですがText Blazeを利用してみます。問題文を読み取る、回答までが作成したコマンドで可能です。

{openai-text: 医師国家試験の過去問です、解答してください。特に指定がなければ1つのみ選択。:{=text}}

{text={site: text; selector=#intro}}

結果ですが第115回のA問題~F問題まで60問解かせてみて21問正解、正解率は35%という結果でした。画像付きの問題は答えられないので文章の問題のみ答えさせています。5択なのでランダムで回答すると20%が正解率の期待値なので適当に答えているよりはましなのですがまだまだといったところです。

“Chat GPT、すごい”、っていうニュアンスでの報道が多いのですが医学知識に関しては今一つの結果でした。しかしコマンド1つでいろいろと活用できることがわかりましたので今後Chat GPTに知識が増えていけば人間に追いつき追い越していく日も遠くないのかもしれません。

コメント